Пару лет назад полиция Великобритании решила создать ИИ, который будет прогнозировать преступления граждан с применением огнестрельного или холодного оружия. Планировалось, что перспективная технология снизит уровень насилия и поможет потенциальным нарушителям выпутаться из сложных жизненных ситуаций. На разработку выделили около 10 миллионов фунтов и потратили два года, но в итоге проект провалился из-за ошибки в обучении нейросети.

Предсказать преступление

В 2018 году стало известно, что полиция Великобритании запускает проект National Data Analytics Solution (NDAS). Предполагалось, что в рамках этой инициативы специалисты под руководством правоохранителей из графства Уэст-Мидлендс разработают прототип системы, способной на основе машинного обучения и статистики предсказывать насильственные преступления, которые в будущем может совершить тот или иной гражданин. Речь, в частности, шла о вероятных нападениях с использованием огнестрельного и холодного оружия.

Ещё тогда, в 2018-м, полиция сообщала, что это первый в мире проект подобного рода. На начальном этапе команда разработчиков собрала более терабайта данных, поступивших из полицейских баз. В них содержалась информация об обысках, задержаниях и уже совершённых преступлениях. Всего данные содержали сведения о примерно 5 миллионах человек.

Полиция подчёркивала, что власти не будут использовать систему для упреждающих арестов. Напротив, идея состояла в выявлении потенциальных преступников для дальнейшего оказания помощи со стороны социальных или медицинских работников. Впрочем, такой подход всё же поднял новые этические вопросы. Например, лондонский Институт Алана Тюринга в отдельном докладе отметил, что NDAS руководствуется благими намерениями, но вот возможность неточных прогнозов вызывает опасения — к тому же неясно, несёт ли общественную пользу превентивное вмешательство в жизнь человека, который не совершил насильственное преступление.

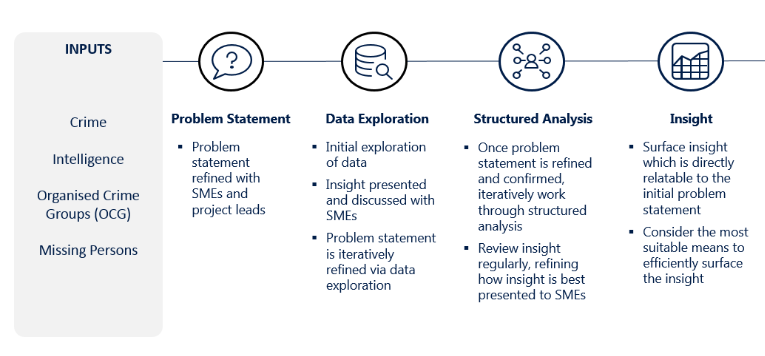

Вводные данные для MSV. Скриншот: westmidlands-pcc.gov.uk

В американском Университете округа Колумбия идею NDAS тоже встретили с беспокойством. Профессор права Эндрю Фергюсон заметил, что система может усилить необъективность правоохранителей, поскольку аресты коррелируют с дислокацией участков, а не с местами совершения преступлений, и это, как правило, непропорционально сказывается на жителях бедных районов и цветном населении.

Как всё оказалось в реальности

За два года МВД Великобритании влило в проект NDAS не менее 10 миллионов фунтов стерлингов (966 миллионов рублей), и к 2020-му система, получившая название Most Serious Violence (MSV), была готова. За это время команда сумела выделить 20 ключевых прогностических критериев, по которым ИИ мог определять вероятных преступников. К ним, помимо прочего, относились:

- Поведенческие критерии — с их помощью машина оценивала прошлое человека на основе полицейских данных. Под ними подразумевались возраст, количество уже совершённых преступлений (без применения насилия), время с момента совершения последнего преступления, количество случаев, когда человек упоминался рапортах или сам становился жертвой, и другие подобные вещи. Полиция утверждала, что эти сведения брались только из зарегистрированных инцидентов в базах правоохранителей и не использовали информации о расе или местонахождении гражданина.

- Сетевые критерии — с их помощью машина изучала, как человек связан с лицами, которые уже обвинялись в совершении тяжких преступлений. По мере того, как такая сеть связей менялась со временем, можно было предположить, что гражданин втягивается в потенциально опасный круг общения.

Рассчитывалось всё просто. За каждый критерий начислялся балл риска, и чем выше балл, тем больше вероятность, что человек в будущем совершит преступление с использованием огнестрела или ножа.

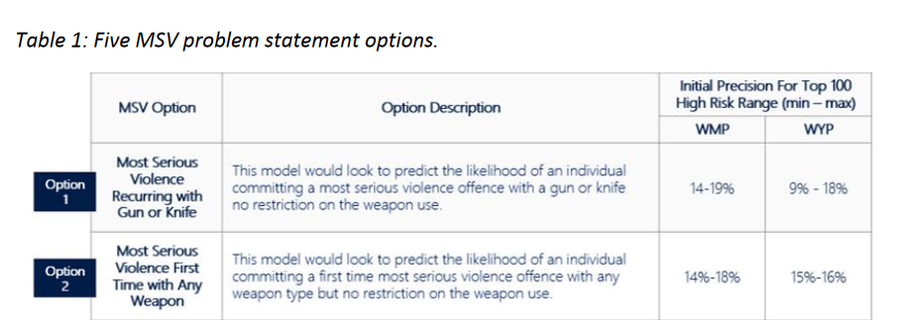

Систему хотели протестировать в некоторых регионах, а затем распространить на всю страну. Перед экспериментальным запуском команда NDAS отчитывалась, что MSV, обученная на данных о 3,5 миллионов человек, имеет точность до 75%. Но сразу после тестового «ввода в эксплуатацию» начались проблемы — точность системы оказалась значительно ниже.

Как выяснилось, на стадии «определения учебного набора данных» разработчики допустили «ошибку кодирования», которая снизила точность MSV. Из-за этого специалисты не могли установить «точку вмешательства» до того, как человек совершит первое правонарушение». Такая ошибка делала систему фактически нежизнеспособной. Разработчики попытались её исправить, но после корректировки критериев точность системы упала до ничтожных 9–19%.

В результате Комитет по этике, закреплённый за проектом и состоящий из экспертов, единогласно отклонил предложение о запуске системы. Ник Дейл, руководитель проекта NDAS, также признал провал — он отметил, что в нынешнем виде MSV работать не может. Тем не менее в полиции отметили, что система прогнозирования более прозрачна, чем другие подобные системы в области охраны правопорядка.

—Тот факт, что Комитет задаёт вопросы и получает на них ответы, является неслыханным в разработке полицейских ИИ-систем. Обычно разработка держится в тайне до тех пор, пока не возникнут проблемы из-за влияния [систем] на людей в реальной жизни

советник Комиссара полиции Уэст-Мидлендса Том Макнейл

Точность модели до и после корректировки. Скриншот: westmidlands-pcc.gov.uk

В полиции также сообщили, что сырая модель MSV никогда не использовалась для реальных операций. Будет ли команда продолжать разработку, пока неясно, но эксперты полагают, что сейчас создать точную прогностическую систему такого типа крайне сложно.