В июне 2020 года калифорнийский город Санта-Крус стал первым в США, запретившим использование системы прогнозирования преступлений. На основе «больших данных» она должна была предсказывать места будущих преступлений, преступников и их жертв, но в итоге алгоритм «обвинили» в расизме и запретили.

Санта-Крус был одним из первых городов в Штатах, экспериментировавших с этой технологией, когда в 2011 году он опробовал и принял программу прогнозирования полицейской деятельности, которая сейчас работает в десятках городов по всей Америке. Технология использовала старые и текущие данные о преступности для разбивки города на блоки размером 150х150 метров для точного определения областей, которые, вероятно, станут местом будущего преступления. Спустя 9 лет городской совет единогласно проголосовал за её запрет из-за опасений, что она укореняет расовое неравенство.

Фото: The New York Times

Что такое прогнозирующая политика?

Постановление Санта-Крус, запрещающее применение этой технологии, определяет её как «ПО, используемое для прогноза в отношении будущих преступлений, включая характеристики и профиль любого человека, который может совершить преступление, место и частоту совершения преступлений, а также потенциальных жертв».

Предиктивная система анализирует огромный объём информации, включая время суток, погоду, типы жертв и местоположений, чтобы сделать главный вывод — когда и в каких местах может произойти преступление. Например, если несколько преступлений было совершено в переулках по четвергам, алгоритм сообщит правоохранителям, что они должны отправлять офицеров в переулки каждый четверг. Правда, одновременно это означает, что полиция предрасположена с подозрением относиться ко всем, кто окажется в этом районе в это время.

При менее распространенном «персональном» прогнозировании это принимает форму рейтинговых систем, когда людям присваивают значение риска на основе ряда данных о них. Подобные рейтинговые системы практически всегда непрозрачны и могут привести к попаданию человека в «чёрный список», как это было в Чикаго в 2017 году. Вряд ли это можно назвать полноценным прогнозом, но вот подвергнуть людей преследованию и наблюдению со стороны полиции без каких-либо фактических доказательств система вполне способна.

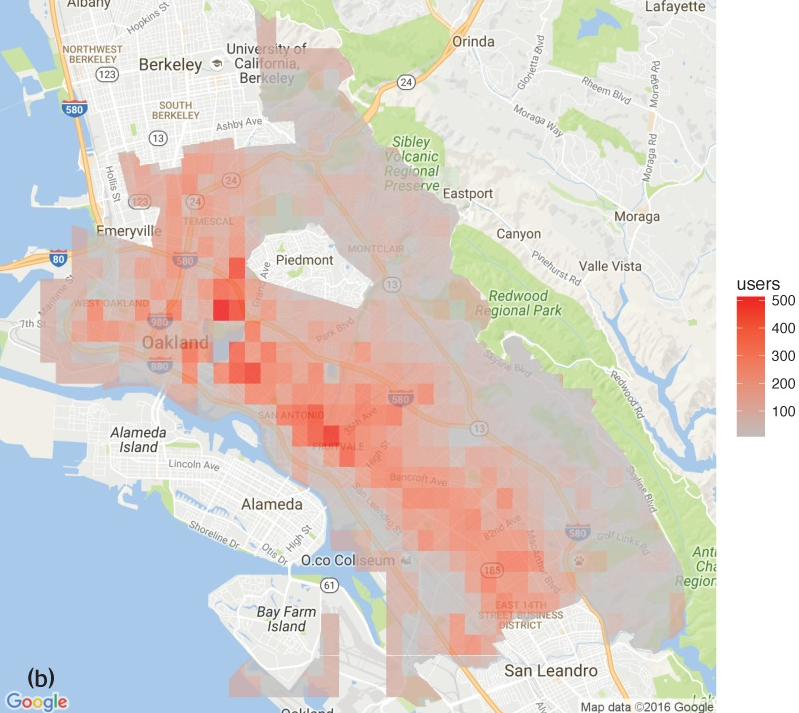

Прогноз числа наркопотребителей в Окленде. Источник: rss.onlinelibrary.wiley.com

В чем проблема?

Прогнозирование преступлений — самоисполняющееся пророчество. Система учитывает только зарегистрированные преступления, поэтому районы и сообщества, в которые полицию вызывают чаще — общины мигрантов или цветные районы, могут с большей вероятностью «привлечь внимание» системы и сконцентрировать там полицейские ресурсы. А если полиция сосредоточит свои усилия в одном районе это приведет к росту задержаний, зачастую за мелкие нарушения, которые в других случаях остались бы без внимания, а увеличившееся число арестов пометит этот район в системе, как очаг преступности. И круг замкнется.

После того, как 15-летнего подростка из Флориды арестовали за кражу велосипедов, алгоритм стал регулярно отправлять полицию к его дому, чтобы те почаще проверяли его и членов его семьи. За пять месяцев они приходили к нему домой 21 раз, появились в его спортзале и на работе родителей. В одном только округе Паско, где живет подросток, офис шерифа с 2015 года нанес 12500 подобных превентивных посещений. Часто они приводили к другим, не связанным с этим арестам, которые, в свою очередь, еще больше повышали вероятность того, что людей снова будут навещать и преследовать.

В одном инциденте мать подростка оштрафовали на $2500, когда полиция, приехавшая для проверки ее ребенка, заметила на заднем дворе 5 цыплят. В другом случае арестовали отца, когда прибывшая полиция увидела в окно их дома курящего 17-летнего подростка. Это виды преступлений, о которых обычно не сообщается, которые происходят во всех районах, во всех экономических слоях, но наказываются только те люди, которые живут под постоянным надзором полиции.

15-летний Рио Войтеки, которого полиция навещала 21 раз. Фото: Tampa Bay Times

Часто подобные алгоритмы основываются на некорректных и непрозрачных источниках, таких как базы данных о бандах. Например, в Лос-Анджелесе, если полиция заметит человека в спортивной майке во время короткого разговора с кем-то на улице, этого может быть достаточно для включения его в базу данных. Люди из этих баз подвергаются большему преследованию со стороны полиции, и могут получить более суровые приговоры. Получается, что система учится на необъективных данных из полицейских управлений.

Многих беспокоит отсутствие прозрачности при создании таких систем. Зачастую неясно, как они разрабатываются и какие данные используют. Их разработчики не разглашают информацию, прикрываясь коммерческой тайной. Инструменты контроля, основанные на таких данных, представляют собой черные ящики, и становится невозможным оценить риски, связанные с частотой ошибок, ложными срабатываниями, предвзятой информацией или ошибками в исходном коде.

Этим летом группа математиков из американских университетов бойкотировала систему предсказания преступлений и отказалась помогать полиции разрабатывать подобные инструменты. Они утверждали, что их знания хотят использовать для «контрабанды расистских идей в широкую общественность через научную легитимность».

Наконец, прогнозирование преступлений вызывает конституционные проблемы. Простое проживание или времяпрепровождение по соседству с определенными людьми может вызвать подозрения у полиции и заставить их рассматривать людей как потенциальных преступников, в то время как полиция должна использовать только проверенные факты.

Брайана Аллена в 2018 году ошибочно включили в члены банды. Фото: latimes.com

Вывод

Эксперимент Санта-Крус показал, что в области прогнозирования технологии пока не могут заменить человека, влияние общества и комплексные меры по снижению преступности. Чем больше полиция полагается на технологию, чтобы определить, где сосредоточить усилия и к кому относиться с подозрением, тем больший вред это наносит.

В США начинает набирать силу движение за запрет правительственного использования распознавания лиц и прочего биометрического наблюдения. Во многих городах по всей стране полиции уже запретили использовать распознавание лиц, после нескольких случаев ложного обвинения и «склонностях» к расизму.

Члены сообщества верят, что еще не поздно бороться с бесконтрольной слежкой и непрозрачными алгоритмами, и это именно то, к чему нам нужно стремиться.